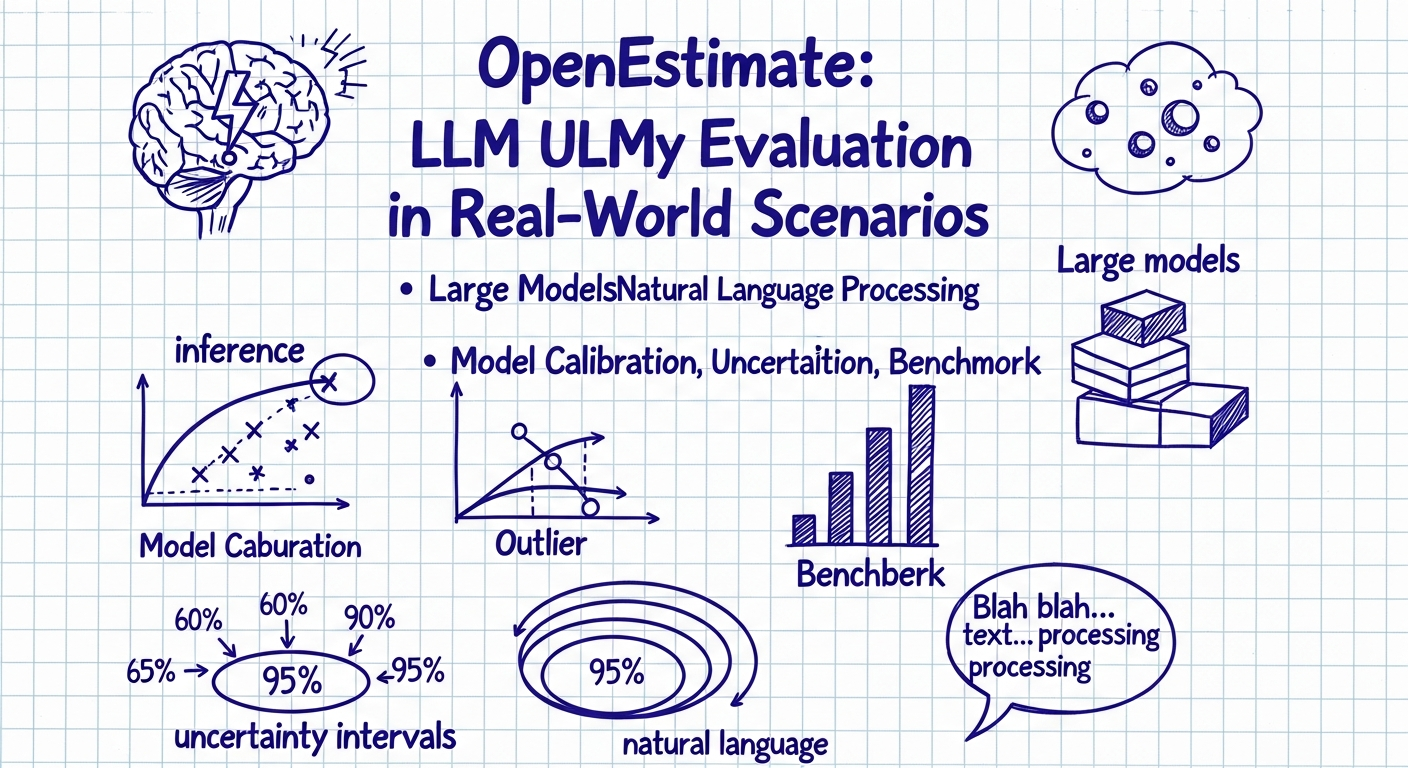

OpenEstimate: הערכת מודלים לשוניים גדולים (LLMs) ביכולת הסקה תחת אי־ודאות באמצעות נתוני עולם אמיתי

יישומי המאמר

פתרון זה משרת מנהלים ומקבלי החלטות בתחום טכנולוגיה ומוצר: OpenEstimate מספק מדד ומערכת בדיקה לבחינת כמה לחיזויים וכאשר מודל "בטוח מדי" או "לא מסביר" על הערכות מספריות. עבור חברות שמפתחות שירותים עם LLM (תחזיות שוק, סיווג סיכונים, תמיכה קלינית מופשטת), הכלים והמדדים מאפשרים לזהות אילו מודלים ניתנים לפריסה בבטחה, היכן צריך לבצע כיול (calibration), ואיך לפרש טווחי אמון שמודלים מדווחים. גם לארגונים משפטיים ורגולטוריים התוצאות רלוונטיות — להבטיח שמודלים מדווחים חוסר-וודאות במפורש ולא מעניקים אמון מופרז בתשובותיהם.

TL;DR

המחקר מציג OpenEstimate — מסגרת וערכת נתונים לבחינת מודלים שפתיים גדולים (LLMs) ביכולת לבצע הערכות כמותיות ולנסח חוסר-וודאות (uncertainty) בהקשרים מעולמות-אמיתיים. החוקרים אוספים אלפי משימות הערכה ממשיות חוצות-דומיינים (כלכלה, בריאות, סקרים, תשתיות ועוד), מגדירים פורמטים סטנדרטיים לבקשת טווחים ואמירות הסתברותיות, ומפתחים מדדים להערכת דיוק, כיול וכיסוי אינטרוולים. בניסויים על סדרת מודלים מסחריים ופתוחים (כולל GPT‑4 וסדרות של LLM פתוחים) מראים החוקרים שחלק מהמודלים מסוגלים לתת הערכות שימושיות אך נוטים להיות מופרזים בביטחון (overconfident) ותוצאותיהם אינן מכוסות היטב על ידי טווחי אמון שמדוּוחים. עבודה זו מדגישה את החשיבות של הערכות כיול וייצוג חוסר-וודאות לפני פריסה למערכות תומכות החלטה במצבים רגישים.

פירוט המאמר

רקע ומטרה

המאמר מציג את OpenEstimate — מסגרת ניסויית לבחינת יכולות של מודלים לשוניים גדולים לבצע הערכות מספריות ולייצג חוסר-וודאות בהקשרים מעשיים. המחקר נבנה על ההבנה כי הערכת ביצועים של LLMs ברוב הבenchmarks מתמקדת על תשובות חד-ערכיות, בעוד שבמקרים רבים במציאות נדרשת הערכת טווחים, סבירות ואמירה על אי-וודאות. המטרה: לאסוף משימות אמיתיות, להגדיר פורמט בדיקה אחיד, ולמדוד דיוק וכיול של הערכות LLM.

ערכת הנתונים — OpenEstimate

החוקרים אספו קבוצה רחבה של משימות הערכה ממקורות פתוחים — דיווחים פיננסיים, נתוני בריאות ציבורית, סקרים, דוחות ממשלתיים ומקורות נתונים מדעיים. הערכה כוללת כמה אלפי פריטים (המאמר מציין סדר גודל של עשרות אלפי שאלות/הערכות בשלב האיסוף; בדיקות המאקרו נעשו על תת-קבוצות בנות כמה אלפי דוגמאות). לכל משימה סופקו ערכים מקוריים (ground truth) או טווחי אמת כאשר רלוונטי. משימות מכסות דומיינים שונים כדי לבחון הכללה חוצת-תחומים של המודלים.

עיצוב המשימות והפרוטוקול

הקבוצה עיצבה פורמטים אחידים לשאילת מודלים: (א) חיזוי נקודתי (point estimate), (ב) חיזוי טווח (interval estimate — לדוגמה טווח 90% אמון), ו-(ג) חיזוי הסתברותי (כימות הסתברות שאירוע יתרחש). בנוסף הוגדרו דרישות מענה (הסבר קצר, ציון רמת בטחון). החוקרים בדקו פרוטוקולי prompting שונים, כולל הוראות פשוטות, chain-of-thought, ובקשות מפורשות לייצר רשתות אי-וודאות.

מדדים ואנליזות

נבחרו מדדי דיוק וכיול: שגיאה ריבועית ממוצעת (RMSE) על הערכות יחסיות/נורמליות, Brier score להערכות הסתברותיות, מצלמות כיסוי אינטרוולים (coverage) מול הכיסוי הנומינלי המבוקש, ו-Expected Calibration Error (ECE) להערכת כיול ביטחון. החוקרים השוו גם למדד בני-אדם על תת-קבוצות.

ניסויים

הערכת המודלים כללה דגימות מ־GPT‑4 (גרסאות שונות), מספר מודלים מסחריים נוספים וכן מודלים פתוחים (למשל Llama‑2 family ורכיבים מסחריים/מחקריים אחרים). לניסויים נבדקו אסטרטגיות prompting שונות והשפעת כיול אחרי-התהליך (post-hoc calibration) והשימוש ב-chain-of-thought.

ממצאים עיקריים

- המודלים הגדולים בדרך-כלל מספקים הערכות שימושיות מבחינת דיוק נקודתי, אך נוטים להציג ביטחון יתר: כיסוי אינטרוולים המדווחים נמוך מהכיסוי הנומינלי. לדוגמה, עבור אינטרוולים של 95% המדווחים, הכיסוי האמיתי היה בממוצע משמעותית נמוך יותר (הפרשי עשרות נקודות באחוזי כיסוי בין מודלים פתוחים למודלים מסחריים מובילים).

- מדדי כיול (ECE) מראים כי אף המודלים הטובים ביותר לא היו מכוילים באופן מהימן; מודלים מסחריים עמדו טוב יותר במקרים מסוימים אבל עדיין הציגו אי-התאמות מהותיות.

- פרוטוקולי prompting ותכנון פלט (למשל בקשות מפורשות לטווחי אמון או שימוש ב-chain-of-thought) שיפרו דיוק וכיול בחלק מהמקרים, אך לא פתרו את הנטייה הכללית של overconfidence.

- כיול אחרי-העובדה (post-hoc calibration) שנבדק השיג שיפורים בכיסוי אך דרש דוגמי אימון שתואמים לדומיין; כלומר פתרון כללי ושיטתי לעומת שיוך דומיין-ספציפי נותר אתגר.

ניתוח והסברים

החוקרים מצביעים על מספר גורמים התורמים לבעיות: העדר סטים מאוזנים של דוגמאות לערכים קיצוניים, נטיות ב-pretraining כלפי ניסוח תשובות ודפוסי prompt-sensitivity. בנוסף ההבדלים בין דומיינים מראים שמודלים נוטים להיות "טובים" בדומיינים עשירים בנתונים ולא מספקים ביצועים שוויוניים בדומיינים נדירים.

מגבלות והצעות להמשך

המחקר מדגיש כי OpenEstimate מהווה התחלה אך דורש הרחבה: יותר דומיינים, שקיפות על מקורות ground-truth ותיאום של פרוטוקולי כיול. בנוסף, יש לבחון אינטגרציה של הערכות חוסר-וודאות במערכות החלטה ולהעריך השלכות פרקטיות.

מסקנה

OpenEstimate מדגים את הצורך במדדים ומבחני כיול ייעודיים ל־LLMs כאשר הם נדרשם לתת הערכות מספריות בעולם האמיתי. המודלים מציגים בקיאות מסוימת בביצוע הערכות אך עדיין אינם אמינים מבחינת ייצוג חוסר-וודאות — תופעה שמסכנת פריסה במערכות רגישות. העבודה קוראת לפיתוח שיטות כיול, עיצוב prompts מובהק והרחבת ערכות הנתונים כדי להבטיח פריסה בטוחה ואחראית של מודלים אלה.

✨ היילייטס

Highlights

- מציגים OpenEstimate — מסגרת וערכת-בדיקה ליכולת LLMs לבצע הערכות כמותיות ולייצג חוסר-וודאות בהקשרים מעשיים.

- תוצאות ניסוי רחבות מעל כמה מודלים מראות מגמה של "ביטחון יתר" (overconfidence): אינטרוולים שמדווחים ב-95% אורחים מכסים חלקית בלבד בפועל.

- פרוטוקולי prompting ויישומי כיול אחרי-התהליך משפרים ביצועים באופן חלקי, אך עדיין קיימות אי-התאמות משמעותיות בין דומיינים ומודלים.

- המלצה מעשית: ארגונים צריכים לבדוק כיול והסתברות מדווחת לפני פריסת LLMs בתחומים רגישים, ולהשתמש בנתוני דומיין לשיפור הכיסוי והאמינות.